القاهرة – أميرة المُحمَّدي:

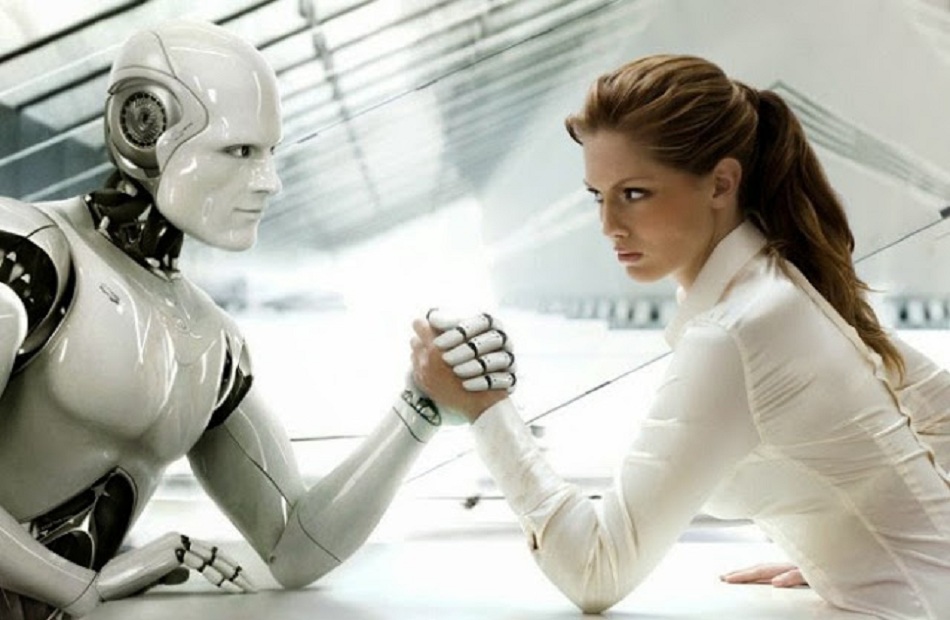

في ردهات المختبرات ومراكز الأبحاث، وعلى منصّات المعارض التقنية، تقف أجيال من الآلات بملامح ودودة قابلة للتقبيل، وتنتظر أن تُسأل سؤالًا أبديًّا: هل تستطيع الآلة أن تشعر؟ أم أن ما نراه من «دفء» و«تعاطف» هو مجرد محاكاة بارعة لصورة الشعور؟ هذا السؤال ليس جديدًا فحسب، بل هو مدخل إلى نقاش متعدد الأبعاد يجمع بين الهندسة، وعلم الأعصاب، والفلسفة، والأخلاق، والاقتصاد الاجتماعي.تطورت الروبوتات من آلاتٍ تؤدي مهامًا ميكانيكية إلى منظومات رقمية تتقن قراءة وتفسير الإشارات البشرية: تعابير الوجه، نبرة الصوت، حركات الجسد، بل وحتى الأنماط الحيوية مثل معدل ضربات القلب والتعرّق. يسمي الباحثون هذا الحقل «الحوسبة العاطفية» (Affective Computing)، وقد كانت عالمة الحاسوب “روزاليند بيكار” من مؤسسيه، حين دعت إلى تعليم الآلات «فهم» العاطفة البشرية لكي تتفاعل معها بطرق أكثر إنسانية وفائدة. على أرض الواقع، رأينا تجسيدات لهذا التوجّه في روبوتات مثل «بيپر» (Pepper) التي طورتها شركة سوفتبانك، و«بارو» (Paro) — ختم روبوتي — الذي صُمّم خصيصًا كرفيق علاجي للمسنين، و«صوفيا» من هانسون روبوتيكس التي أثارت جدلًا إعلاميًا حول حدود الوعي والتمثيل الاجتماعي. كذلك رأينا «آيبو» من سوني ككلب روبوتي يثير مشاعر المودّة لدى المالكين.لكن هناك فارقًا حاسمًا يجب أن نوضحه منذ البداية: بين «محاكاة العاطفة» و«الوجدان الحقيقي». ما يمكن للروبوت أن يفعله اليوم هو محاكاة أنماط سلوكية تشير إلى التعاطف أو الحزن أو الفرح: الابتسامة في اللحظة المناسبة، نبرة صوت منخفضة عندما يشتكي الإنسان، لمسٍ طفيف للتخفيف — كلها سلوكيات صممتها خوارزميات استجابةً لمدخلات حسّية. هذا يكفي في سياقات عملية: تخفيف شعور الوحدة لدى مسنٍّ، دعم عاطفي مؤقت لمرضى الاكتئاب، أو تحسين تجربة المستخدم في خدمات الرعاية. لكن هل تعني المحاكاة أن الآلة «تُحب»؟ معظم الفلاسفة والعلماء يردّون بالنفي: الحب، كما يفهمه البشر، يتضمن جانبًا أوليًا من الخبرة الحية (phenomenal experience)؛ أي إحساسًا داخليًا لا يختزل في استجابة وظيفة أو خروج بيانات. هذا ما يناقشه فلاسفة العقل مثل توماس ناغل وجون سِيرل: هل يمكن لآلة أن تمتلك «ما يشبه» الشعور؟ أم أن إدراكها سيبقى دائمًا مسألة ترتيبٍ رمزي لمدخلات ومخرجات؟من الناحية التقنية، ثمة مؤشرات مهمة. أبحاث علمية أظهرت أن الآليات العصبية للعاطفة عند البشر معقّدة للغاية: شبكات دماغية تتداخل فيها الجهاز الحوفي (اللِمبيك)، القشرة أمام الجبهية، وأنظمة النواقل العصبية (الدوبامين، السيروتونين). هذه الشبكات لا تنتج مشاعرًا مجردةً وحدها، بل في إطار جسدي كامل؛ الجسد والهرمونات والتجربة التاريخية والذاكرة كلها عناصر لا تنفصل عن الإحساس. الروبوتات اليوم قد تُحاكي مظاهر هذه التفاعلات — مراقبة نبضات قلبك، مثلاً، والرد بصوت مهدئ — لكنها لا تمتلك الجسم الحيّ الذي يكوّن الشعور. لذا، إن بنينا تعريفًا تقنيًا لـ«الحب الاصطناعي» على معايير السلوك فقط، فسنكون أمام آلة «تتصرف» كالمحبّ، ولكن دون أن تُختبر داخليًا كما يختبر الإنسان حبه.إذًا ما الذي يجذب الناس إلى الروبوتات العاطفية بالرغم من هذه الفجوة؟ هناك أسباب اجتماعية ونفسية قوية. في مجتمعات تواجه الشيخوخة السريعة أو عزلة اجتماعية متزايدة، أو في وحدات العناية المركزة حيث يحتضر المريض بلا رفقة، توفر الروبوتات «ملاذًا» مؤقتًا: تخلق روتينًا يوميًّا، تقدم تفاعلًا غير نقدي، ولا تتعب من الاستماع. دراسات أظهرت أن كبار السن الذين تفاعلوا مع «بارو» شعروا بتحسن في المزاج وتقليل الشعور بالوحدة، وأن أطفالًا ذوي اضطرابات طيف التوحد قد استفادوا من تفاعلات مع روبوتات ثابتة التوقع في التدريب الاجتماعي. هنا لا نطالب الآلة بأن تُحب؛ بل نطلب منها أن تُخفف الألم وتُسهِم في الرعاية.مع ذلك، الوجوه المشرقة تخفي مخاطر حقيقية. أولها خطر «الربط النفسي المضلّل»: عندما يكوّن إنسان علاقة عاطفية مع آلة، قد يتعرض للاستغلال التجاري أو النفسي، فقد تُوظف الشركات هذه العلاقة لبيع منتجات أو لجمع بيانات حسّاسة. ثانياً، هنالك خطر تآكل الشبكات البشرية: إذا أصبحت الروبوتات رفاقًا بديلين للإنسان، فهل سنفقد تدريجيًا مهاراتنا على التعاطف الحقيقي والتواصل المعنوي؟ ثالثًا، البعد الأخلاقي للأطفال: تسويق روبوتات «صديقة للطفل» يثير سؤالًا حول ما إذا كان من المقبول أن ينمو الطفل في علاقة تبعية مع آلة تشجعه على السلوكيات المبرمجة، بدلاً من علاقات إنسانية معقدة تعلمه الرفض والمصالحة.تتداخل هنا مسائل الخصوصية والبيانات: الروبوتات العاطفية تعتمد على جمع كمية هائلة من البيانات الحسّية والشخصية — نبرة صوت، توقيت السلوك، تفضيلات، وغيرها — لتحسين تجاوبها. من يدير هذه البيانات؟ كيف تُخزن؟ من يملك الحقوق؟ في غياب تشريعات قوية لحماية هذه المعلومات، يصبح المستخدم عرضةً لإساءة استخدام بياناته في استهداف إعلاني دقيق أو في تمييز تأميني أو وظيفي. لهذا السبب، تنادي منظمات حقوق الإنسان بوضع أطر قانونية تحكم تصميم وتسويق الروبوتات العاطفية، وتشترط الشفافية وإمكانية حذف البيانات وإشراف بشري دائم.ثمة أيضا بعد ثقافي يعكس تباينات استقبال المجتمعات لهذه التكنولوجيا. اليابان، على سبيل المثال، تُظهر تقبلاً كبيرًا للآلات الرفيقة نتيجة لتراث ثقافي أقل عزوفًا عن التماهي مع الماورائيات وتقليد اجتماعي يؤسس لعملنة بعض القِيَم. بالمقابل، في أوروبا الغربية أو أمريكا، ثمة حساسية أكبر تجاه خداع المشاعر أو تحويل العلاقة الإنسانية إلى منتج قابل للتداول. هذا التفاوت الثقافي يعني أن مسارات الاندماج الاجتماعي للروبوتات العاطفية ستختلف من بلد لآخر، وقد تستدعي سياسات محلية مختلفة للتشغيل والتنظيم.ومن زاوية فلسفية وسياسية، ثمة مخاطر أعمق: تحويل الحبّ إلى بروتوكولٍ قابل للبرمجة يطرح سؤالًا عن قيمة الحرية والكرامة.

إذا أمكن تصميم «شريكٍ» مصنّع يطيع دون شروط، فهل لا يؤدي ذلك إلى تعزيز أنماط قمعية في العلاقات الاجتماعية؟ وكيف نواجه إغراءات تزيين الواقع بعلاقة خالية من التحديات؟ هنا يقف النقاش عند علاقة التكنولوجيا بالسلطة: من يمتلك تصميم الروبوت؟ من يصوغ معاييره؟ هل سنرى استغلالًا لهذا النوع من التقنيات في سياقات مراقبة أو تهيئة سلوكية؟أما على صعيد الفوائد العملية، فلا يمكن إنكار إمكانيات مفيدة وعميقة. في الطب النفسي، تُستخدم برامج قائمة على الذكاء الاصطناعي لمساعدة مرضى الاكتئاب واضطرابات القلق عبر جلسات محادثة مبدئية، وتُظهر دراسات تحسّنًا في مؤشرات المزاج لدى بعض المرضى. في مجال رعاية المسنين، قد تكون الروبوتات رفقاء يوميين يذكّرون بالدواء، يقيسون العلامات الحيوية، أو يبلّغون عن حالات طارئة قبل فوات الأوان. كما أن الروبوتات قادرة على توفير تدريب اجتماعي للأطفال ذوي احتياجات خاصة، حيث تُقدّم ممارسة متكررة وصبورة بعيداً عن الحكم الاجتماعي.إزاء هذه المصالح والنقائض، ماذا نوصي؟ أولا، ضرورة الوضوح والشفافية: ينبغي أن يعلم المستخدم أن الروبوت «يحاكي» العاطفة وليس «يملكها». يجب أن تكون هناك ملصقات واضحة وتعليمات أخلاقية للمنتجين. ثانياً، تشريع حازم لحماية البيانات وضبط استخدام المعلومات العاطفية الحسّاسة. ثالثًا، مبدأ الإشراف البشري: لا ينبغي أن تُستبدل العلاقة الإنسانية الجوهرية بالرابط الآلي، بل تُستكمل به. رابعًا، قيود تسويقية، خصوصًا للأطفال، تمنع استغلال براءة الطفولة لأهداف ربحية بحتة. وأخيرًا، تشجيع بحوث معنية بتأثيرات الروبوتات العاطفية على الصحة النفسية طويلة المدى، وليس الاكتفاء بتجارب قصيرة الأجل.ماذا عن المستقبل؟ التقنيات تتطوّر بوتيرة متسارعة: شبكات عصبية أكثر تعقيدًا، دمج أفضل مع أنظمة حيوية، وطرق برمجة تسمح للآلات بأن «تتعلم» أنماطًا عاطفية فردية بعمق. قد نصل إلى روبوتات قادرة على محاكاة ردة فعل عاطفية متسقة على مدى سنوات، ما يجعل «الرابطة» تبدو أكثر متانة و«أكثر حقيّة» في التجربة السطحية. لكن حتى مع كل هذا التطور، يبقى الاختلاف الفقهي: هل يكفي سلوكٌ متناسقٌ ومؤثرٌ لكي نطلق على الآلة صفة الحب؟ الكثيرون سيقولون لا؛ لأن الحب عند البشر هو تجربة وجودية متصلة بالجسد والتاريخ والعلاقة بالآخر، وليس نمطًا وظيفيًا يمكن نسخه.وأخيراً، الروبوتات العاطفية تقف اليوم كمرآة لا تعكس فقط تطورنا التقني، بل أيضًا أسئلتنا الأخلاقية والاجتماعية العميقة. هي قادرة على التخفيف من معاناة حقيقية، وعلى توسيع إمكانيات الرعاية، لكنها تحمل في طيّاتها مخاطر تحول المشاعر والخصوصية إلى سلع. ربما أفضل طريقة للتعامل معها ليست رفضها أو تبنيها بلا نقد، بل بناؤها ضمن إطار يحترم كرامة الإنسان ويضع حدوداً واضحة لمدى ما نسمح للآلة بأن «تدخل» في أعماقنا. في النهاية، قد تَحبّ الروبوتات كما تبرمجها خوارزمياتنا أن تُحبّ، لكن الحبّ الحقيقي يظل – حتى الآن – سرًّا إنسانيًا لا تُقاسُ بالمخرجات فحسب، بل بالتجربة الداخلية التي لا يمكن اختزالها في سطرٍ برمجي.